Sesgos en los datos, el riesgo en los modelos predictivos de inteligencia artificial

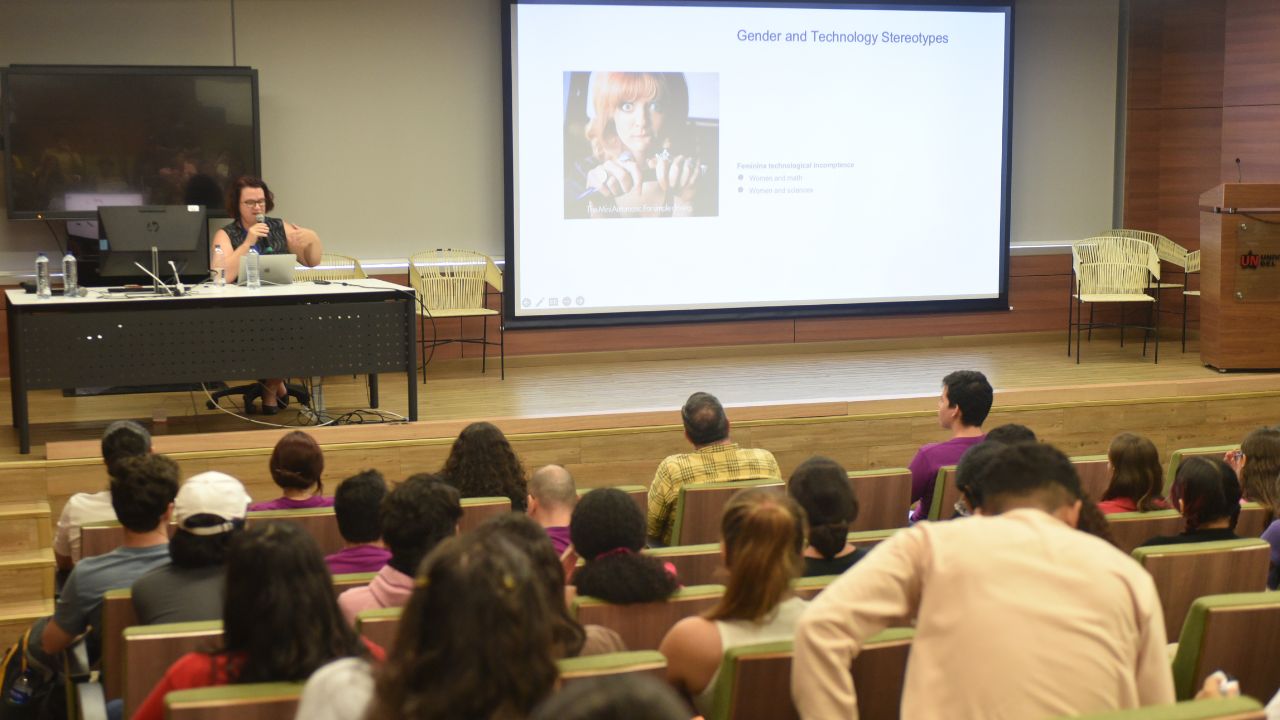

La diseñadora y programadora Frederique Krupa reflexionó sobre la preocupación latente que se tiene por el crecimiento de aplicativos de I. A. que replican sesgos que la humanidad ha intentado mitigar. Subrayó en la necesidad de abrir el debate alrededor de estos problemas de la tecnología.

Mientras los desarrollos de inteligencia artificial siguen avanzando de forma acelerada, en muchos casos descontroladamente, hay quienes empiezan a hacer el llamado a la reflexión para dimensionar el alcance de este tipo de herramientas, principalmente aquellas que acceden a bases de datos de información para responder a cualquier pregunta que se le haga. Frederique Krupa, directora del Digital Design Lab de la Escuela de diseño de Nantes Atlantique (Francia), considera que aspectos como la falta de diversidad de género en el campo de la programación limita su potencial innovador e influye en la creación de sistemas de inteligencia artificial cargados de sesgos.

Krupa estuvo como invitada a la Cátedra Europa Uninorte 2023 y presentó la conferencia "Género, diseño y tecnología: el poder de la diversidad para un desarrollo inclusivo de la I. A.", que se llevó a cabo el miércoles, 4 de octubre. En su intervención, se refirió a uno de los debates actuales que se ha promovido por la incursión de la inteligencia artificial basada en modelos predictivos: lo referente a los sesgos que replican.

Los modelos predictivos funcionan de la siguiente forma: inicialmente se toma una gran cantidad de datos que son incluidos como una muestra para la inteligencia artificial; esta data es clasificada de acuerdo con los parámetros que especifiquen sus programadores y luego son aplicados algoritmos que, con base en la información que fue introducida, pueden predecir un resultado al detectar patrones.

Krupa manifestó que uno de los problemas de este modelo es que la data introducida viene con sesgos en la mayoría de los casos. Citó el caso de Imagenet, un set de data que incluía millones de imágenes y asociaba etiquetas hechas inicialmente por programadores y voluntarios, y posteriormente rellenadas a través de machine learning. Esto provocó que muchas de estas etiquetas tuvieran categorías racistas, sexistas y homofóbicas. Con el tiempo estas etiquetas fueron actualizadas, pero el problema persiste en otros sets de data que son utilizadas en diversas inteligencias artificiales.

Otro caso de problemas con los algoritmos es el de reconocimiento facial, que es efectivo para personas de tez blanca, pero imprecisos para personas de color, debido a que las bases de datos utilizadas no tienen suficiente representación de personas de tez oscura. Esto ha llevado a escándalos judiciales, como lo ocurrido a Porcha Woodruff, una mujer negra de Detroit, quien fue arrestada cuando estaba con ocho meses de embarazo debido a que un software de reconocimiento facial la confundió con una persona que era buscada por robo de autos.

De acuerdo con la invitada, estas falencias de la inteligencia artificial son alarmantes, pues esta tecnología se está utilizando en diversas áreas, como en recursos humanos para elegir candidatos a potenciales trabajos. Lo especialmente preocupante para Krupa es que no son los programadores los que están al frente de estos análisis de las falencias de la inteligencia artificial, sino científicos sociales que trabajan para que estos sesgos en la data sean reconocidos y mejorados.

“En este momento, muchos de los ingenieros se han centrado tanto en hacer que los modelos funcionen bien, por eso la búsqueda del rendimiento realmente supera la noción de si es aceptable utilizar estas tecnologías”, reflexionó Krupa. Los cambios, añadió, solo pueden ocurrir cuando hay un cuestionamiento y crítica abierta al status quo que generan discusión alrededor de esta situación.

Más noticias

Dic 17, 2024

Histórico

español

español inglés

inglés francés

francés alemán

alemán